主配置文件

INFO

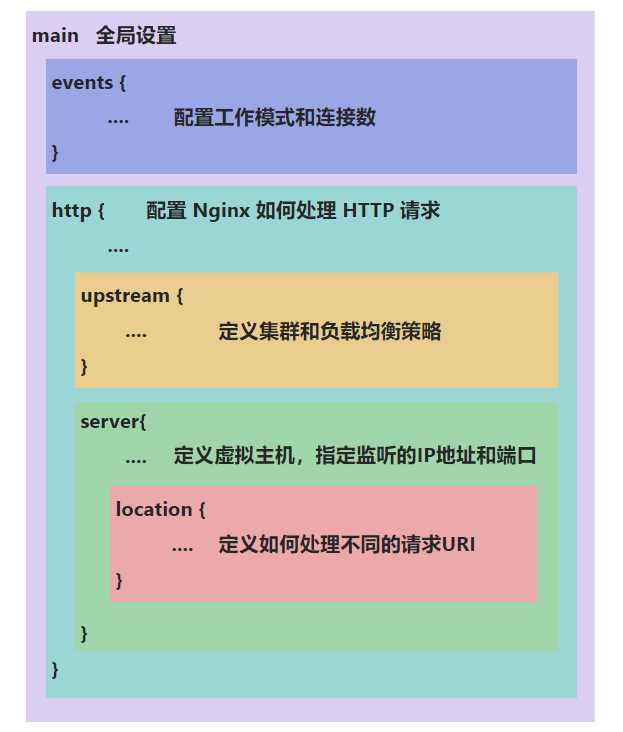

nginx.conf:这个是Nginx的核心配置文件- 官方文档:https://nginx.org/en/docs/

nginx.conf

常用配置

#定义Nginx运行的用户和用户组

user www www;

#nginx进程数,建议设置为等于CPU总核心数.

worker_processes 8;

#全局错误日志定义类型,[ debug | info | notice | warn | error | crit ]

error_log /var/log/nginx/error.log info;

#进程文件

pid /var/run/nginx.pid;

#一个nginx进程打开的最多文件描述符数目,理论值应该是最多打开文件数(系统的值ulimit -n)与nginx进程数相除,但是nginx分配请求并不均匀,所以建议与ulimit -n的值保持一致.

worker_rlimit_nofile 65535;

#工作模式与连接数上限

events{

#参考事件模型,use [ kqueue | rtsig | epoll | /dev/poll | select | poll ]; epoll模型是Linux 2.6以上版本内核中的高性能网络I/O模型,如果跑在FreeBSD上面,就用kqueue模型.

use epoll;

#单个进程最大连接数(最大连接数=连接数*进程数)

worker_connections 65535;

}

#设定http服务器

http{

include mime.types; #文件扩展名与文件类型映射表

default_type application/octet-stream; #默认文件类型

charset utf-8; #默认编码

server_names_hash_bucket_size 128; #服务器名字的hash表大小

client_header_buffer_size 32k; #上传文件大小限制

large_client_header_buffers 4 64k; #设定请求缓

client_max_body_size 8m; #设定请求缓

#开启目录列表访问,合适下载服务器,默认关闭.

autoindex on; #显示目录

autoindex_exact_size on; #显示文件大小 默认为on,显示出文件的确切大小,单位是bytes 改为off后,显示出文件的大概大小,单位是kB或者MB或者GB

autoindex_localtime on; #显示文件时间 默认为off,显示的文件时间为GMT时间 改为on后,显示的文件时间为文件的服务器时间

sendfile on; #开启高效文件传输模式,sendfile指令指定nginx是否调用sendfile函数来输出文件,对于普通应用设为 on,如果用来进行下载等应用磁盘IO重负载应用,可设置为off,以平衡磁盘与网络I/O处理速度,降低系统的负载.注意:如果图片显示不正常把这个改成off.

tcp_nopush on; #防止网络阻塞

tcp_nodelay on; #防止网络阻塞

keepalive_timeout 120; #(单位s)设置客户端连接保持活动的超时时间,在超过这个时间后服务器会关闭该链接

#FastCGI相关参数是为了改善网站的性能:减少资源占用,提高访问速度.下面参数看字面意思都能理解.

fastcgi_connect_timeout 300;

fastcgi_send_timeout 300;

fastcgi_read_timeout 300;

fastcgi_buffer_size 64k;

fastcgi_buffers 4 64k;

fastcgi_busy_buffers_size 128k;

fastcgi_temp_file_write_size 128k;

#gzip模块设置

gzip on; #开启gzip压缩输出

gzip_min_length 1k; #允许压缩的页面的最小字节数,页面字节数从header偷得content-length中获取.默认是0,不管页面多大都进行压缩.建议设置成大于1k的字节数,小于1k可能会越压越大

gzip_buffers 4 16k; #表示申请4个单位为16k的内存作为压缩结果流缓存,默认值是申请与原始数据大小相同的内存空间来存储gzip压缩结果

gzip_http_version 1.1; #压缩版本(默认1.1,目前大部分浏览器已经支持gzip解压.前端如果是squid2.5请使用1.0)

gzip_comp_level 2; #压缩等级.1压缩比最小,处理速度快.9压缩比最大,比较消耗cpu资源,处理速度最慢,但是因为压缩比最大,所以包最小,传输速度快

gzip_types text/plain application/x-javascript text/css application/xml;

#压缩类型,默认就已经包含text/html,所以下面就不用再写了,写上去也不会有问题,但是会有一个warn.

gzip_vary on;#选项可以让前端的缓存服务器缓存经过gzip压缩的页面.例如:用squid缓存经过nginx压缩的数据

#开启限制IP连接数的时候需要使用

#limit_zone crawler $binary_remote_addr 10m;

#虚拟主机的配置

server

{

#监听端口

listen 80;

#域名可以有多个,用空格隔开

server_name wangying.sinaapp.com;

index index.html index.htm index.php;

root /data/www/;

location ~ .*\.(php|php5)?$

{

fastcgi_pass 127.0.0.1:9000;

fastcgi_index index.php;

include fastcgi.conf;

}

#图片缓存时间设置

location ~ .*\.(gif|jpg|jpeg|png|bmp|swf)$ {

expires 10d;

}

#JS和CSS缓存时间设置

location ~ .*\.(js|css)?$ {

expires 1h;

}

#日志格式设定

log_format access '$remote_addr - $remote_user [$time_local] "$request" '

'$status $body_bytes_sent "$http_referer" '

'"$http_user_agent" $http_x_forwarded_for';

#定义本虚拟主机的访问日志

access_log /var/log/nginx/access.log access;

#

#设定查看Nginx状态的地址.StubStatus模块能够获取Nginx自上次启动以来的工作状态,此模块非核心模块,需要在Nginx编译安装时手工指定才能使用

location /NginxStatus {

stub_status on;

access_log on;

auth_basic "NginxStatus";

auth_basic_user_file conf/htpasswd;

#htpasswd文件的内容可以用apache提供的htpasswd工具来产生.

}

}

}负载均衡 upstream

负载均衡策略

轮询

轮询是 upstream 模块负载均衡默认的策略,每个请求会按照顺序被分配到后端的服务器,不需要额外的配置。

但是我们可以配置后端服务器的权重,后端服务器可能有的性能比较好,那么权重可以设置的高一些,默认权重为 1,数字越大,被分配到请求的几率越大

被分配的几率是 = 当前服务的权重 / 所有权重之和

# 负载均衡配置

upstream backserver {

server localhost:8080 weight=5;

server localhost:8081 weight=2;

server localhost:8082 weight=1;

}ip_hash

ip_hash 策略,根据客户端 IP 地址分发请求,使来自同一 IP 地址的请求总是分发到同一台后端服务器。

当用户在后端服务器 1 上登录后,session 在服务器 1 上,后面请求如果分发到其他服务器上,就获取不到登录状态。ip_hash 策略就是应对这种情况,但是现在很多都是移动网络,设备 IP 经常变化,所以这种模式也很少用了,一般通过服务端将登录信息保存到 Redis 中或使用无状态的 jwt 来处理

# 负载均衡配置

upstream backserver {

ip_hash; # 负载均衡策略

server localhost:8080;

server localhost:8081;

server localhost:8082;

}least_conn

least_conn 策略,将新请求分发给当前连接数最少的服务器。有时候有的请求可能占用的时间很长,导致其所处理的服务器负载较高,在服务器初始启动或重启后,所有服务器的连接数都为零,因此第一个服务器可能会处理所有初始请求,直到其他服务器逐渐开始接收请求

# 负载均衡配置

upstream backserver {

least_conn; # 负载均衡策略

server localhost:8080;

server localhost:8081;

server localhost:8082;

}url_hash

通过计算请求 URL 的哈希值,将请求分配给后端服务器。这样相同 URL 的请求总是被分配到同一个后端服务器。通过这种策略可以实现缓存命中最大化。

要使用 url_hash 负载均衡策略,需要安装并启用 ngx_http_upstream_hash_module 模块。

# 负载均衡配置

upstream backserver {

hash $request_uri; # 负载均衡策略

server localhost:8080;

server localhost:8081;

server localhost:8082;

}fair

fair 负载均衡算法会监控后端服务器的响应时间,并将新请求分配给平均响应时间最短的服务器。这样做的目的是确保每个请求都能尽快得到处理,从而提高应用的整体响应速度。

Nginx 本身不直接支持 fair 负载均衡策略,但可以通过第三方模块 nginx-upstream-fair 实现。该模块需要在编译 Nginx 时加入。

# 负载均衡配置

upstream backserver {

fair; # 负载均衡策略

server localhost:8080;

server localhost:8081;

server localhost:8082;

}七层负载均衡

# 服务器1

server {

listen 8080;

server_name localhost;

default_type text/html;

location / {

return 200 'server: 8080';

}

}

# 服务器2

server {

listen 8081;

server_name localhost;

default_type text/html;

location / {

return 200 'server: 8081';

}

}

# 服务器3

server {

listen 8082;

server_name localhost;

default_type text/html;

location / {

return 200 'server: 8082';

}

}

# ------上面配置的是服务器1/2/3,下面是负载均衡配置------

# 反向代理服务器

# 设置服务器组,也就是上面的三台服务器

upstream backserver {

server localhost:8080;

server localhost:8081;

server localhost:8082;

}

server {

listen 80;

server_name localhost;

location / {

# backend 就是服务器组的名称

proxy_pass http://backserver/;

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

proxy_set_header X-Forwarded-Proto $scheme;

}

}